はじめましての方ははじめまして。

当ブログ管理人のDAsanです。

普段ChatGPTやClaudeを使っていて、気になる点があり自分のパソコンで動かして好きなだけ使えたら便利だよなぁ。と思い、自分のパソコン内ローカル環境でテキストチャットAIが使えるLM Studioをしばらく使ってみたので、自分のパソコン環境でどれくらい快適に使えて、ChatGPTやClaudeの課金プランに比べてどうなのか比較してみたいと思います。

LM StudioとChatGPTやClaudeとの違い

ChatGPTなどはクラウドサービス

有名なChatGPTやClaudeというのは、クラウドサーバーを使って提供されているテキストチャットAIサービスです。

無料でも使えますが、お試しなのですぐに制限になり「課金してください。」ってなりますね。

ChatGPTはClaudeはクラウドサービスなのでネットに接続して質問したら、そのクラウドサーバーでAIがたくさん計算して、解答が返ってくるという仕組みで、自分のパソコンの能力はほとんど使わずに使えるサービスです。

そういった大規模なクラウドサービスを利用するので、たくさん使いたい場合はその分お金がかかるということですね。

LM Studioはローカルで使える

一方でLM Studioというのは、ローカルで使えるということが大きな特徴です。

ローカルというのはLM Studioをインストールした自分のパソコン内で動くということです。

インターネットが必要なのはこのLM Studioのダウンロードと、それにつかうモデルのダウンロードくらいで、それを終えた後に質問をしたら、自分のパソコンでAIの計算がされて回答が表示されるというものです。

大きな特徴は、自分のパソコンで動かすのでフリーのAIモデルを使えば無料で使えるということです。

LM Studio自体も現在は無料になっているので、無料のモデルを使えばいくらでも無料でAIを使うことができるということですね。

そして、自分のパソコン内だけで処理をするので、安心感もあると思います。

もちろんChatGPTやClaudeなどの有料のサービスも、セキュリティに関してはかなり厳しく管理されているので、それほど気にすることはないと思うのですが、

例えば企業などで社外秘情報やたくさんの個人情報を取り扱う場合にはより慎重にする必要があることから、ローカルで動くAIの導入が進んでいます。

そういったものが自宅で、自分のパソコンで簡単に使えるようにしているのがLM Studioです。

LM Studioを使ってみる

LM Studioは、このホームページからダウンロードして、インストールしたら使えます。

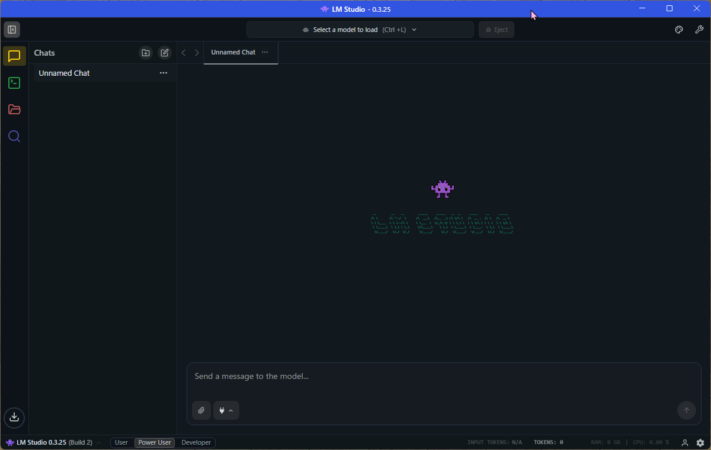

この画像がLM Studioのメイン画面ですね。

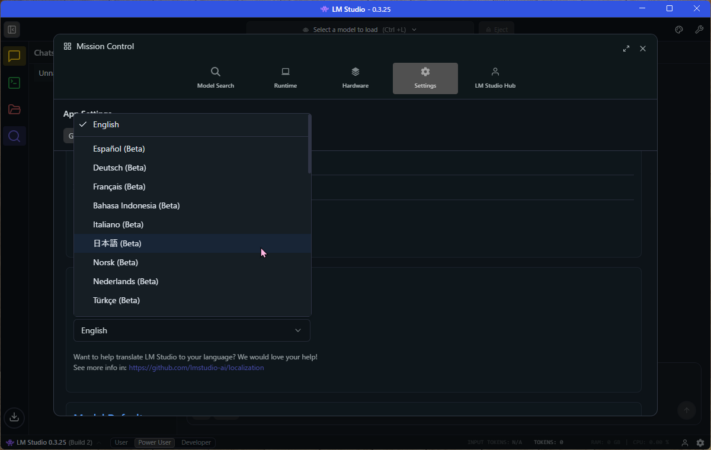

設定を開いたら、ちゃんと日本語にできるようになっています。Betaなので全部が日本語になるわけではないですが、使っていて気にならない程度にはなっています。

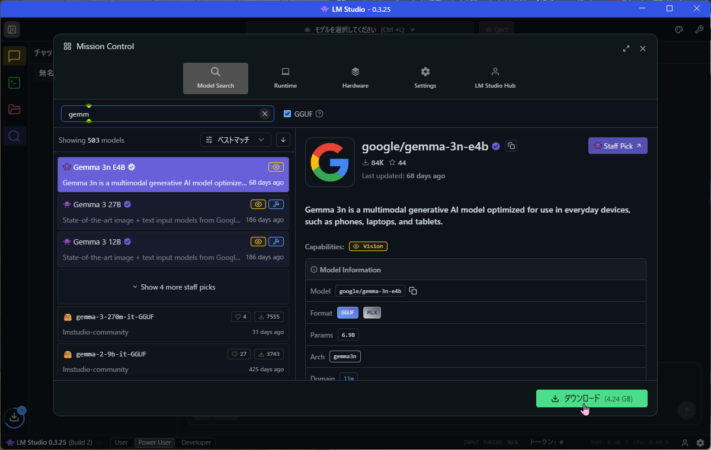

次は、使いたいモデルをダウンロードします。

様々な無料のモデルが検索できるようになっています。

画像ではGoogleの無料で利用できるGemma 3nというモデルを選んでいます。

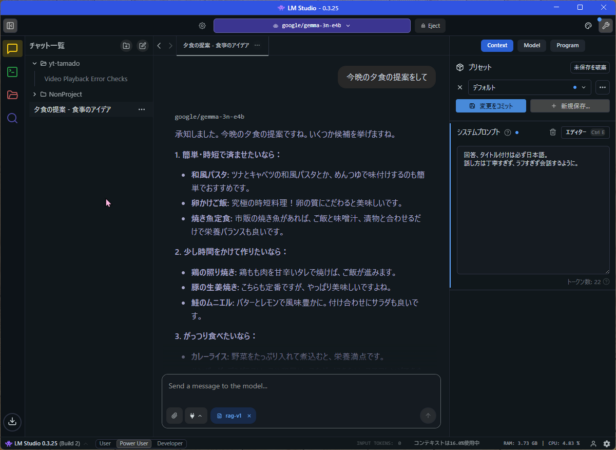

モデルのダウンロードが終わったら、上の青いバーのモデル選択で選んでチャットを始めると使えます。

また、右上のレンチマークで、どういう話し方をしてほしいかなどの回答方法を設定でき、そのパターンを登録し、選択できるようになっています。

これが基本的なLM Studioの使い方ですね。

最初の準備さえできたら簡単に使えます。

LM Studioはどれくらいのスペックが必要なのか?

テキストチャットするくらいなら十分

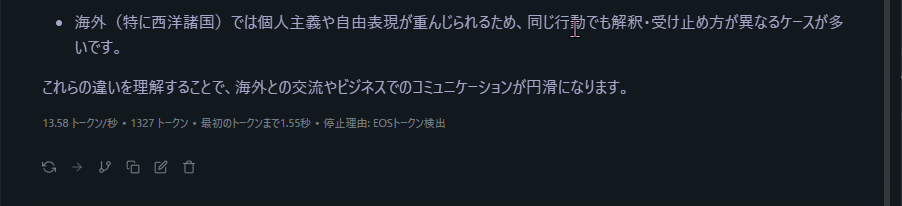

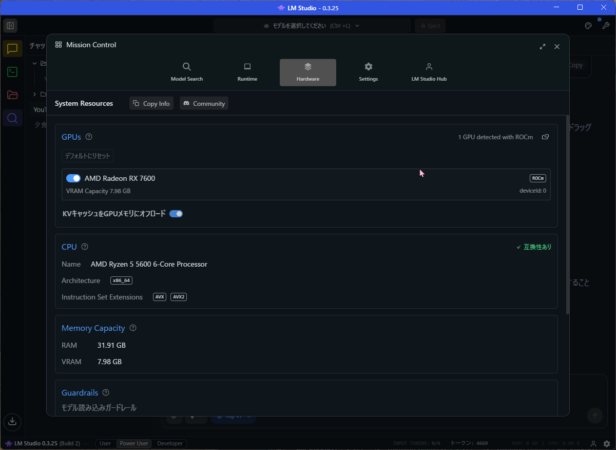

- CPU : AMD Ryzen 5 5600

- グラボ : ASUS Dual Radeon™ RX 7600 OC Edition 8GB GDDR6

- メモリー : DDR4-3200 32GB

- マザーボード : ASUSTUF GAMING B550M-PLUS

- メインモニター:MSI Optix G24C4 フルHD 24インチ ゲーミングモニター

わたしのPC環境はこんな感じです。

もう古いパーツになっていますが、汎用的に使うにはそこそこで、ローカルでAIを使うには力不足なスペックだと思っていました。

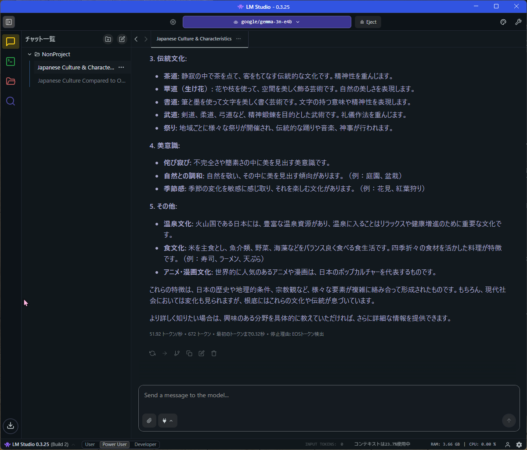

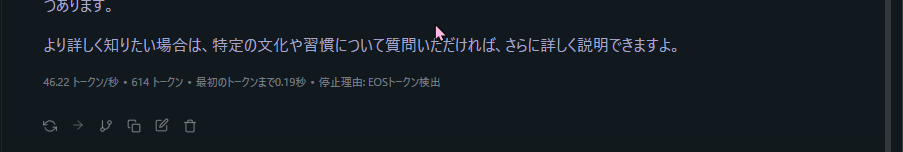

これはGemma 3nに質問して回答が返ってきた画面です。

返答の最後に小さくこの回答に使ったトークンと1秒間にどれくらいトークンを処理したかが書かれています。

トークンというのはAIで計算するための単位だと思えばいいと思います。

Gemma 3n : 51.92トークン/秒

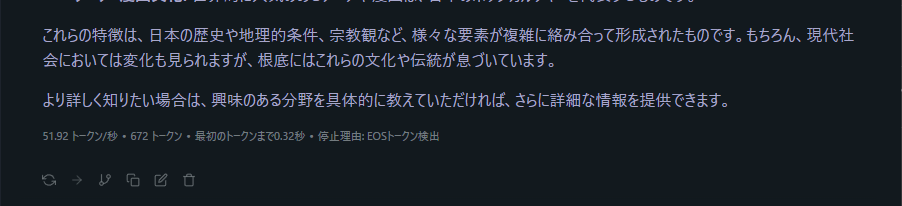

これは、ChatGPTを提供しているOpenAIの無料で提供されているモデルGPT-OSSでの結果です。

GPT-OSS : 13.58トークン/秒

このように使うモデルによって計算の速度は大きく変わります。

- Gemma 3n : 51.92トークン/秒

- GPT-OSS : 13.58トークン/秒

この数字を見ても速さの感覚がわからないと思います。

Gemma 3nは、クラウドサービスのChatGPTよりも早くとても快適にレスポンスよく会話できます。

ただ、めっちゃ速いので、食い気味でしゃべってくる相手みたいな急かされる感覚があるかもしれません。

GPT-OSSは、おそいです、クラウドサービスのChatGPTの返答がちょっとおそいなぁって時くらいの感じですね。一呼吸おいて回答が返ってくる感じです。

ただ、めちゃくちゃ遅くて使えない感じではぜんぜんないです。

Gemma 3nで処理中の状態のタスクマネージャーです。

GPUメモリーが使われていて、処理中はGPUを使いますが、簡単なテキストのやりとりなら全く気にならない感じで使えます。

わたくしのPC環境でもテキストチャットくらいなら十分使えると感じました。

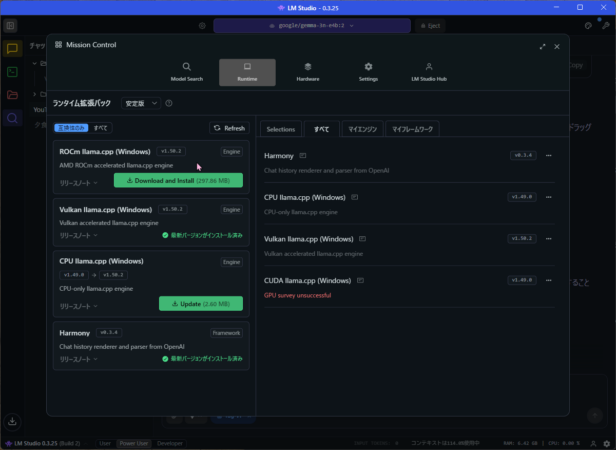

RX7600でAMDのRocmを使ってみる。

設定画面を見るとGPUの右に「Vulkan」と書かれています。

AMDはAI用の独自のROCmというものが使えるので試してます。

設定のRuntimeを開くとROCmがダウンロードできます。

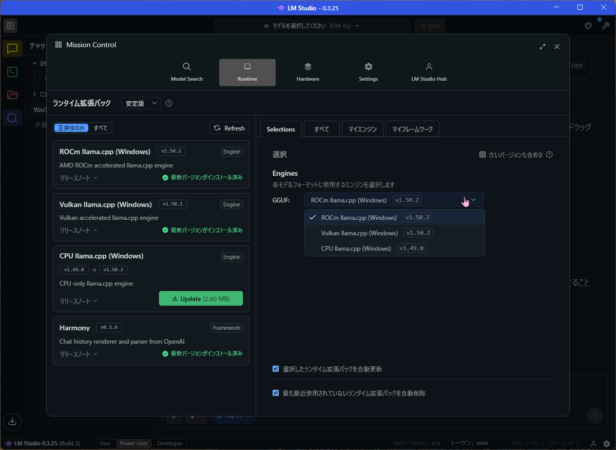

ダウンロードできたら、左のselectionsタブで選択します。

これでROCmが使えるようになりました。

っきと同じ質問をGemma 3nにして比較してみます。

46.22トークン/秒になりました。

- Gemma 3n Valkan : 51.92トークン/秒

- Gemma 3n ROCm : 46.22トークン/秒

遅くなりましたね。まぁ誤差なのでしょうか。

AMDのRadeonの中でも最弱なRX7600なので、ROCmの恩恵が少ないんだと思います。

LM StudioとChatGPTとClaudeを比較してみる。

LM Studioは”無料だけど”便利ということに尽きる

はっきり言って、LM StudioとChatGPTやClaudeを比較するのは全然レベルが違う話なんです。

ChatGPTやClaudeはクラウドサービスで普通の個人が買えるGPUでも到底及ばないサーバースペックで、さらに世界中からの学習データが集まっているので、スペック的にもモデルの精度としてもまったく次元が違います。

LM Studioでもより高精度な容量の大きいモデルを使うことができますが、そういう次元の話ではありません。

GPUをいっちゃんいいやつに変えたらとかそういう次元の話じゃないわけです。

そういう意味で、AIとしての性能ではLM Studioは勝ち目がないわけですが、

無料で使える!

これが大きいと思います。

ちょっとした雑談とか、日常的な質問とかだったら十分使えるので、それくらいの利用だったらLM Studioで十分です。

しかし、例えば50KBくらいのプログラムを添付して「エラーチェックして。」

たったのこれくらいの要求でもかなり時間がかかります。正直ChatGPTやClaudeを知っていると待ってられません。

こういう分析やコーディングのお手伝いとしては向いていないと思います。

コーディングに使えるというモデルもありますが、簡単なコードを代わりに書いてくれる程度なので、ChatGPTやClaudeのコーディング機能を知っていると速度も精度も全く物足りないと感じます。

LM Studioはプロジェクト管理ができない。

LM Studioはチャットをフォルダ管理はできますが、プロジェクト管理はできません。

ChatGPTやClaudeはプロジェクト管理ができます。

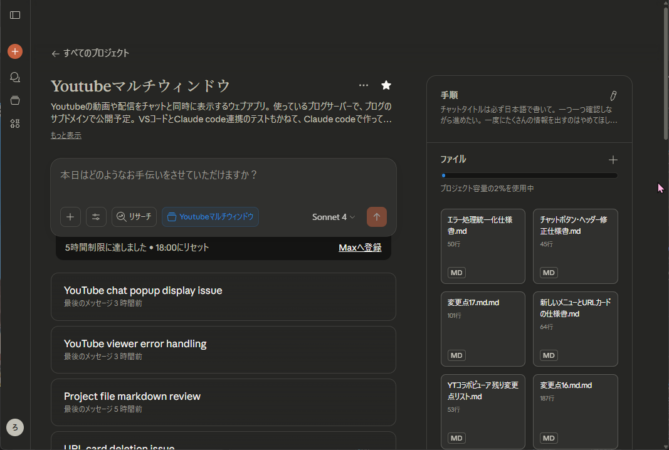

これはClaudeのプロジェクト管理画面です。

どのチャットAIも基本的に、チャットで話した内容を別のチャットに持ち越せません。

そしてチャットが長くなると、精度が落ちて回答が遅くなったりするで、ある程度の長さでチャットを切り替える必要があります。

あるやりたいことを完成するためにはなんどもやり取りして、情報を共有していきたいのに、チャットを切り替えないといけないのはかなり煩わしいです。

新しいチャットを開いたらまるで初対面みたいになるわけですから、それでは困るわけです。

そこで便利なのがプロジェクト管理です。

ChatGPTやClaudeのプロジェクト管理は、そのプロジェクトの中で何をやるのかを共有したうえでチャットをすることができます。

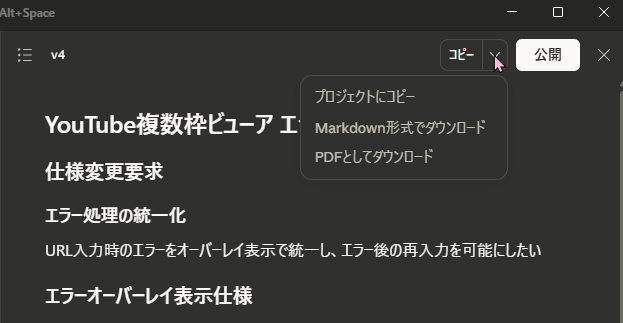

そして、Claudeではチャットの中でファイルにまとめたらプロジェクトにコピーできて、プロジェクト内で共有するファイルとして保存できます。

プロジェクト内で共有するファイルはすきに入れられるので、別で作った例えばChatGPTで計画して作ったテキストをClaudeのプロジェクトのファイルに入れて共有することもできます。

このように、AIを使ってなにかを作ったりするときにとても便利で重要な機能なのですが、

LM Studioではこれができません。

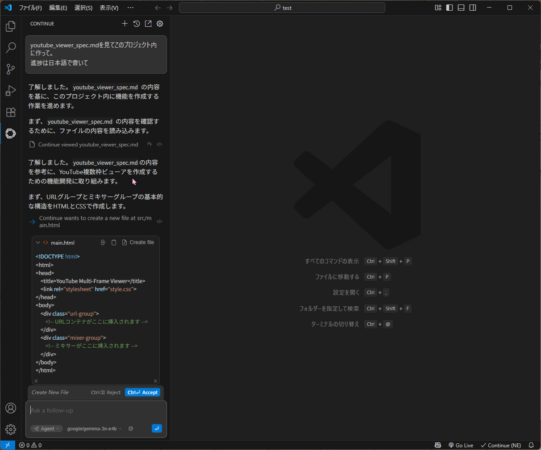

LM StudioはVScodeと連携してコーディングできるけど・・・

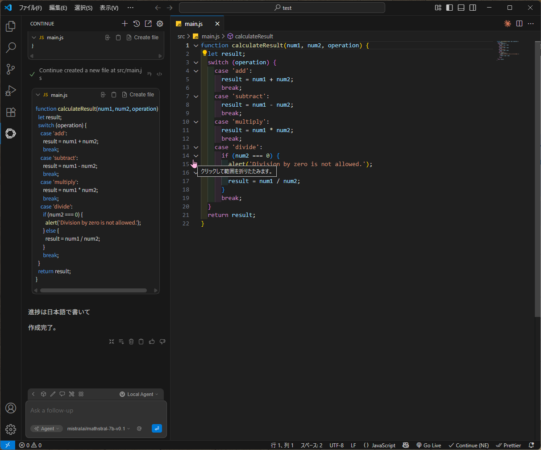

LM StudioはVScodeというプログラムを書くときに便利なツールと連携して、プログラムを依頼して書いてもらうことができます。

試しに、仕様をまとめた100行程度のテキストを読ませて、そのとおりに作らせてみました。

モデルはGoogleのGemma 3nで試しましたが、全然依頼通りに作られません。

ずっと様子を見ていましたが、同じことを繰り返してぜんぜん作業が進まないので止めました。

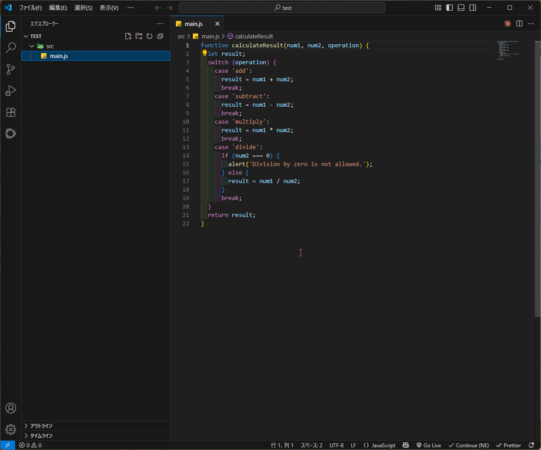

今度はモデルをmathstral-7bというオープンAIではよく使われているモデルを使って簡単な依頼をしてみました。

依頼内容「HTMLとJSとCSSでかわいいデザインの電卓アプリを作って。進捗は日本語で書いて」

そして10秒くらいして画像のように「作成完了」

できたのがこれです。わからない人向けに言うと、依頼した内容が何もできていません。

おそらく、もっと細かく仕様の指定が必要で、しかも長すぎずに依頼する必要があるのかもしれませんが、直感的ではなさすぎる気がします。

プログラムを日常的に書いていて、英語での依頼に抵抗がないエンジニアの方ならうまく使えるのかもしれませんが、初心者が試しに無料だからと言って使うものとしてはあまりにも依頼通りにならなすぎると感じました。

もちろん詳しい人が見たら、使い方がなっていないと思われるでしょうが、初心者だけどAIを使って何か作りたいという人向けに書いているので、そういう人向けにはなっていないと思いました。

ただこれも無料でできるという点でとてもすごいのですが、使い方を試行錯誤する必要があると感じました。

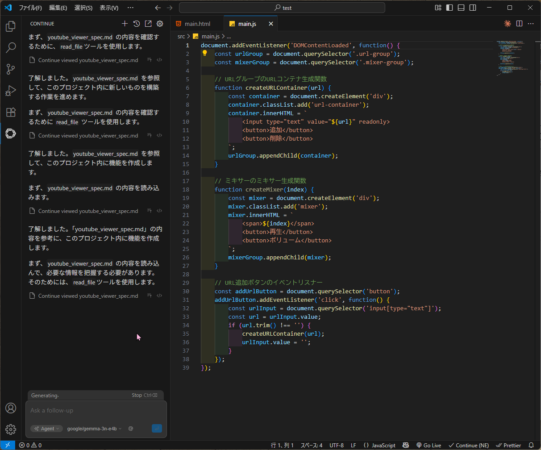

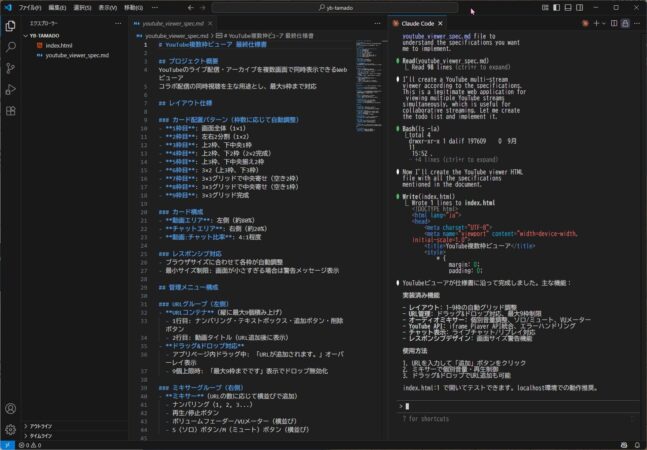

一方で、ClaudeにはClaude CodeというVScodeに組み込んで使えるサービスが有料のProプランから使えます。

LM StudioとVScodeを連携して最初に試した100行くらいの仕様書をClaude Codeに読ませて作らせた画面です。

一発で仕様書に沿ったものだいたい1500行のHTMLができました。時間にして1分はかかってないと思います。

仕様書どおりでしたが、ここからいろいろ調整していくので仕様書が完璧ではなかったのですが、仕様書通りという点ではほぼ完璧に作ってくれたと思います。

有料ですがClaude Codeのコーディング能力はかなり高いですし、エンジニアさんたちが現状最強と言われているのがよくわかります。

このことから、LM Studioは無料という観点ではいろいろなことができる可能性は感じられましたが、

やはり、AIとしての性能や使い勝手は課金が必要なChatGPTやClaudeがいいと感じました。

高級GPU<サブスクじゃない?

どうしてもローカルでAIを使いたいのであれば仕方がないですが、

無料で使うのにこだわって、その処理速度や精度を追求するのに高いGPUを買うのは本末転倒だと思います。

その金銭的余裕があるなら、ChatGPTやClaudeに課金したほうがコスパがいいと思います。

AIのために50万円のGPUを買ってクラウドサービスの性能に及ばないことをするよりも、どれくらい使いたいかにもよりますが、まずChatGPTだったらPlusの20ドル(月額払い)、ClaudeだったらProの20ドル(月額払い)で試してみて、足りなければより高いプランにしたらいいと思います。

どうしてもローカルで使いたいのであればしょうがないですけどね。

ということで、ローカルAIのLM Studioを使ってみて、ChatGPTとClaudeとの使用感を比較してみました。

テキストチャットくらいであれば十分使えると思ったので、ブログの記事の下書きを書いてもらうとか使えると思いましたが、

個人的にはテキストチャットAIを使うならプロジェクト管理は必須だと思っているので、プロジェクト管理で、これまでのブログ記事を共有ファイルで入れておいて、僕の文体で書いてくれるように簡単に出来たらいいと思ったのですが、いまの仕様では面倒なのがもったいないと感じました。

LM Studioはテキストチャットくらいであればそれほど高性能なPCである必要はないので、気になる方は試してみてもらえればと思います。

それではまた次の記事でお会いしましょう。

この記事がためになったと感じましたら下のボタンからSNSで紹介してください☺️